算力已成为学术界、产业界和公众关注的核心话

在需求端,算力分为训练算力和推理算力两部分。训练阶段对算力和精度要求较高,用于建立和优化模型;推理阶段则是在已训练完成的模型上对新数据给出输出,通常对算力和精度的要求相对较低。

全球市场的热潮推动智能算力快速成长,全球范围内训练端的峰值算力需求和云端推理的需求都呈现快速增长的态势。市场主体以通用性较强的 GPU 为主导,训练层面多以英伟达的 A100 与 H100 为核心,推理层面则以 T4 等加速卡为常见选择。当前 GPU 在 AI 算力领域占据主导地位,主流框架对这些芯片的适配与优化也相对成熟。

关于各主流芯片的特性,可以看到:A100 以强大的计算能力、海量显存和多路互联技术(如 NVLink)著称,适合大规模神经网络的训练;H100 作为新一代数据中心级别的加速器,在总体性能和扩展性方面实现显著跃升,对大规模模型训练和推理任务有更强支撑;T4 则以功耗低、推理优化为卖点,适用于需要规模化推理的场景,如图像、语音与自然语言处理等应用。如今,GPU 已成为 AI 算力的核心硬件,厂商与应用场景之间的协同效应日益明显。

不过,随着大模型热潮席卷,高端算力的供给也暴露出明显不足。一些权威分析指出,面向主流大模型的高端 GPU 供需缺口相当大,云服务商、大型互联网公司以及研究机构的需求量往往远超当前产能。由于高端芯片的产能主要来自昂贵的制程与封装工艺,供给端的紧张会直接推动市场价格与采购策略的调整,云厂商与科技巨头往往通过多渠道、多来源来提升供应的弹性。

在大厂自研方面,传统依赖第三方芯片供应的格局逐步改变。微软推出自研的 Maia 100 AI 加速芯片,定位云端训练与推理,尽管官方表态优先自用、逐步向外部开放;谷歌持续迭代自家专用的 Cloud TPU 系列,最新一代在训练和推理性能与成本效益方面进行了优化;亚马逊则在云端提供训练芯片 Trainium 与推理芯片 Inferentia,并将自身基础设施与自研芯片高度融合。与此同时,OpenAI、Anthropic 等也在探索自研芯片或强化供应多元化,以降低对单一厂商的依赖。价格和供给层面的挑战也使得跨厂商协作、并购与投资成为常态。

除了传统巨头外,市场上还涌现出一批新兴芯片公司与替代性方案。部分企业以“推理专用”或“低能耗高效算力”为目标,提出了基于内存计算、脑尺度架构、或混合架构的设计思路,声称在特定任务上能够显著提升推理效率和能效比。这些新兴力量与 AMD、Cerebras、Rain Neuromorphics、d-Matrix 等共同构成了日益多元的竞争格局,向英伟达形成更为广泛的市场挑战。

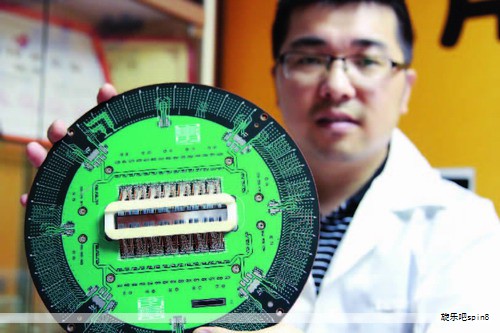

在国内市场,国产算力供给链也在持续增强。华为昇腾系列处理器以自研架构为核心,致力于在云端推理与训练场景中实现稳定高效的算力输出;寒武纪以自研 ASIC 为主,强调在特定场景下的高效算力表现,并逐步走向云端训练与推理的综合能力提升。国内还有燧原科技、沐曦、壁仞科技、天数智芯等企业活跃在算力集群、加速卡与云计算中心的建设中旋乐吧spin8。百度昆仑芯片则在云端推理方面展开应用探索,科大讯飞也在与华为合作的平台上推进国产大模型的训练与推理能力。国产厂商通过与本地云厂商、科研机构的深度协作,力求在核心算力、软件生态及出货规模方面实现稳步突破。

近期,全球算力市场的价格与供需环境呈现波动迹象。部分服务商与云厂商宣布提升算力服务价格,以应对设备成本上涨与资源紧张的局面。行业内也出现对国产替代的期待与试探,企业通过提前锁定芯片采购、扩大自研能力与优化供应链来降低未来的不确定性。

在行业前景方面,全球算力市场正走向更为多元的格局。英伟达在关键领域仍具领先地位,但来自国产厂商、自研云厂商以及初创公司的竞争正在加速形成新的平衡。出口管制与全球供应链的变化也将对全球市场格局产生重要影响,导致各大厂商在短期内都需要通过多元化布局来降低单一来源的风险,并在长期内寻找更稳定、可持续的供给路径。